即刻App年轻人的同好社区

下载

✨大家好~ 我是Simon阿蒙,我现在的身份有:不知道啥时候能毕业的PhD / 佛系自媒体人 / 菜鸟独立开发者 / 断更艺术创作者 / 半个数字游民 / 初创公司打杂人员🐶

👉个人独立站:shengyu.me

✨想成为理解AI,但AI无法取代之人

📑我分享过的有用资源📑:

- 🌟科普教程:

- 我上 AI 顶会啦!CVPR AI Art Gallery 作品极简创作教程 (2024.06): mp.weixin.qq.com

- OpenAI Sora视频生成模型技术报告中英全文+总结+影响分析 (2024.02): mp.weixin.qq.com

- 送立体动态新年红包+最好用的SD客户端+开源视频生成模型 (2024.02): mp.weixin.qq.com

- AI时代抗焦虑指北 —— 被AI包围之后,人类“完蛋”了吗?(2023.12):mp.weixin.qq.com

- AI生成3D问题的简化和解决,以及随之而来的新问题(2023.11):mp.weixin.qq.com

- 如何制造大语言模型的意识幻觉?斯坦福AI小镇论文精读 (2023.09):mp.weixin.qq.com

- ChatGPT基本原理(告诉你为啥它啥都懂)(2023.04):mp.weixin.qq.com

- 从用手建模到用嘴建模:一文说透最新用文字生成三维模型的人工智能算法原理 (2022.10):mp.weixin.qq.com

- 5分钟上手人工智能设计:借AI之力用文字生成图片(无软硬件+前置知识要求,2021.08):mp.weixin.qq.com

- 🌟工具合集:

- 关于声音生成的一切(2024.01):mp.weixin.qq.com

- 关于4D 生成的一切(2024.01):mp.weixin.qq.com

- 关于 chatGPT 的一切(实用工具篇,2023.05):mp.weixin.qq.com

- 关于 ControlNet 的一切(2023.04):mp.weixin.qq.com

- 关于3D 内容人工智能 (AI) 生成的一切(2023.01):mp.weixin.qq.com

- 关于人工智能内容生成(AIGC)的一切(2022.10):mp.weixin.qq.com

😶🌫️

💽AIGC代表作💽:

- 🌟代码开发:

- 我攒了一扇 AI 平行时空传送门——3D gaussian 复杂大场景迁移(2024.04 已暂停):mp.weixin.qq.com

- 我,编程菜鸟,攒了一个用文字生成三维模型的AI工具(Dreamfields-3D,已开源,2022.09):mp.weixin.qq.com

- 🌟艺术商业案例:

- 我如何用AI为小米国际限量版手机做宣传片(2023.03):mp.weixin.qq.com

- AI创作的正确打开方式:雪佛兰×全屏本是×Simon的白日梦 | AIGC商业落地案例复盘 (2023.02):mp.weixin.qq.com

- 国家地理中文网:“守护海洋原住民”系列数字藏品创作(2022.05):mp.weixin.qq.com

- 🌟 AI视频作品:

- ✨微观宇宙:一木一浮生,一空一有无, 一念一无限 (2024.08): b23.tv

- 云端画意 —“古董”AI模型生成复古国风山水动画(2023.07):www.bilibili.com

- 硅基生物图鉴-硅藻云戏者(2023.06):www.bilibili.com

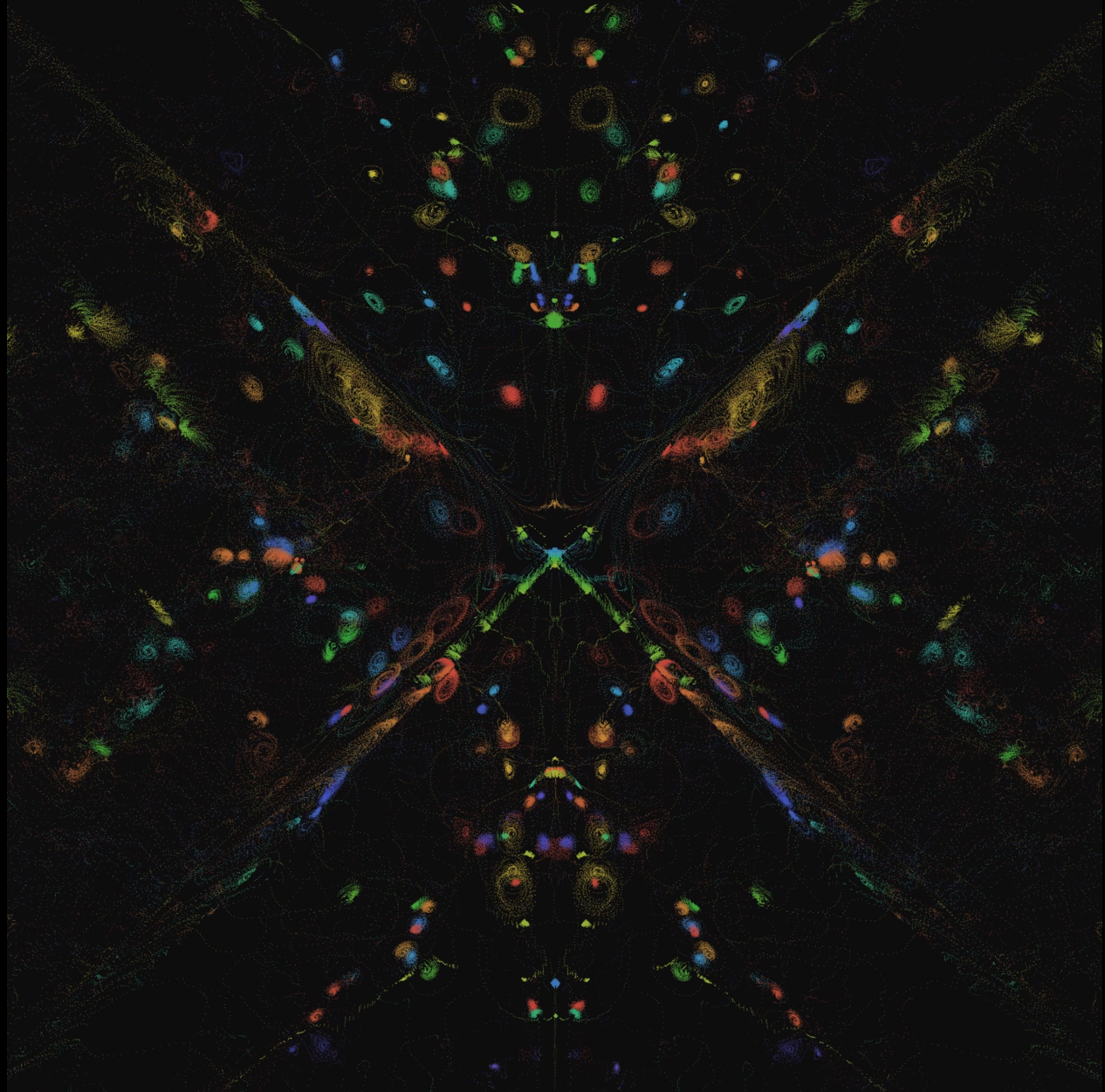

- 量子场-无AI生成艺术(2023.04):www.bilibili.com

- 微观世界极限深潜(2022.10):www.bilibili.com

- 幻时之砂(2021.12):www.bilibili.com

- 超级文明已经组队迁往二次元元宇宙了,而你还没有拿到船票?(2021.12):www.bilibili.com

🎖️AIGC经历🎖️:

- 做过课程或讲座的地方:英国伦敦大学学院 / 奥地利因斯布鲁克大学 / 中央美院 / 小米 / 深圳市插画协会 / 集智俱乐部 / 国际人机交互大会 / 艾厂 / 中国科普作家协会

- 合作过的厂商:小米 / 雪佛兰 / 现代 / 周大福 Tmark / 国家地理中文网

- 参展过的地方:上海设计周 / 上海喜马拉雅美术馆 / 威尼斯元宇宙艺术年展 / 北京Tong画廊 / 郑州海汇美术馆 / 北京-城市建筑双年展 / 伦敦 Zero to One Space / 奥地利-蒂罗尔建筑中心

📻我的社媒📻:

- 公众号 / 视频号 / B站 / 小红书 / 微博:Simon的白日梦

- 我的 AI 自动化创作替身 - CyberGenix:weibo.com

- 知识星球(核心社群):AI白日梦想家 (向我提问,72小时无条件退款,领券:t.zsxq.com)

🥰写在最后🥰:

感谢你读到这里,其实我是一个佛系+拖延的人,能做那么多事情或许真的是因为一直以来大家给我的正反馈,所以我后续会一直在这里更新有用的资源(你可以收藏或者转发这个帖子)。如果你有问题或者希望找我合作,可以私信我也可以发到 📧simondaydream@163.com。如果我48小时后还没有回复,可以再提醒我一次。最后,希望世界和平,愿你身心自在🤗。

👉个人独立站:shengyu.me

✨想成为理解AI,但AI无法取代之人

📑我分享过的有用资源📑:

- 🌟科普教程:

- 我上 AI 顶会啦!CVPR AI Art Gallery 作品极简创作教程 (2024.06): mp.weixin.qq.com

- OpenAI Sora视频生成模型技术报告中英全文+总结+影响分析 (2024.02): mp.weixin.qq.com

- 送立体动态新年红包+最好用的SD客户端+开源视频生成模型 (2024.02): mp.weixin.qq.com

- AI时代抗焦虑指北 —— 被AI包围之后,人类“完蛋”了吗?(2023.12):mp.weixin.qq.com

- AI生成3D问题的简化和解决,以及随之而来的新问题(2023.11):mp.weixin.qq.com

- 如何制造大语言模型的意识幻觉?斯坦福AI小镇论文精读 (2023.09):mp.weixin.qq.com

- ChatGPT基本原理(告诉你为啥它啥都懂)(2023.04):mp.weixin.qq.com

- 从用手建模到用嘴建模:一文说透最新用文字生成三维模型的人工智能算法原理 (2022.10):mp.weixin.qq.com

- 5分钟上手人工智能设计:借AI之力用文字生成图片(无软硬件+前置知识要求,2021.08):mp.weixin.qq.com

- 🌟工具合集:

- 关于声音生成的一切(2024.01):mp.weixin.qq.com

- 关于4D 生成的一切(2024.01):mp.weixin.qq.com

- 关于 chatGPT 的一切(实用工具篇,2023.05):mp.weixin.qq.com

- 关于 ControlNet 的一切(2023.04):mp.weixin.qq.com

- 关于3D 内容人工智能 (AI) 生成的一切(2023.01):mp.weixin.qq.com

- 关于人工智能内容生成(AIGC)的一切(2022.10):mp.weixin.qq.com

😶🌫️

💽AIGC代表作💽:

- 🌟代码开发:

- 我攒了一扇 AI 平行时空传送门——3D gaussian 复杂大场景迁移(2024.04 已暂停):mp.weixin.qq.com

- 我,编程菜鸟,攒了一个用文字生成三维模型的AI工具(Dreamfields-3D,已开源,2022.09):mp.weixin.qq.com

- 🌟艺术商业案例:

- 我如何用AI为小米国际限量版手机做宣传片(2023.03):mp.weixin.qq.com

- AI创作的正确打开方式:雪佛兰×全屏本是×Simon的白日梦 | AIGC商业落地案例复盘 (2023.02):mp.weixin.qq.com

- 国家地理中文网:“守护海洋原住民”系列数字藏品创作(2022.05):mp.weixin.qq.com

- 🌟 AI视频作品:

- ✨微观宇宙:一木一浮生,一空一有无, 一念一无限 (2024.08): b23.tv

- 云端画意 —“古董”AI模型生成复古国风山水动画(2023.07):www.bilibili.com

- 硅基生物图鉴-硅藻云戏者(2023.06):www.bilibili.com

- 量子场-无AI生成艺术(2023.04):www.bilibili.com

- 微观世界极限深潜(2022.10):www.bilibili.com

- 幻时之砂(2021.12):www.bilibili.com

- 超级文明已经组队迁往二次元元宇宙了,而你还没有拿到船票?(2021.12):www.bilibili.com

🎖️AIGC经历🎖️:

- 做过课程或讲座的地方:英国伦敦大学学院 / 奥地利因斯布鲁克大学 / 中央美院 / 小米 / 深圳市插画协会 / 集智俱乐部 / 国际人机交互大会 / 艾厂 / 中国科普作家协会

- 合作过的厂商:小米 / 雪佛兰 / 现代 / 周大福 Tmark / 国家地理中文网

- 参展过的地方:上海设计周 / 上海喜马拉雅美术馆 / 威尼斯元宇宙艺术年展 / 北京Tong画廊 / 郑州海汇美术馆 / 北京-城市建筑双年展 / 伦敦 Zero to One Space / 奥地利-蒂罗尔建筑中心

📻我的社媒📻:

- 公众号 / 视频号 / B站 / 小红书 / 微博:Simon的白日梦

- 我的 AI 自动化创作替身 - CyberGenix:weibo.com

- 知识星球(核心社群):AI白日梦想家 (向我提问,72小时无条件退款,领券:t.zsxq.com)

🥰写在最后🥰:

感谢你读到这里,其实我是一个佛系+拖延的人,能做那么多事情或许真的是因为一直以来大家给我的正反馈,所以我后续会一直在这里更新有用的资源(你可以收藏或者转发这个帖子)。如果你有问题或者希望找我合作,可以私信我也可以发到 📧simondaydream@163.com。如果我48小时后还没有回复,可以再提醒我一次。最后,希望世界和平,愿你身心自在🤗。

59 820

claude code重度使用者急需🥹

ai-claude-start:多配置Claude命令行启动器

GitHub - op7418/ai-claude-start: Multi-profile Claude Code launcher with secure credential management

🧐一句话总结:

该工具是一个可同时管理多个Claude API配置的安全命令行启动器,支持Anthropic、Moonshot、智谱(BigModel)等兼容API,通过系统密钥库安全存储凭证,实现多环境快速切换与一键启动Claude CLI。

➡️链接:github.com

✨重点

● ⚙️ 核心功能:多配置 + 安全凭证管理

支持多个Claude风格API配置(Anthropic / Moonshot / BigModel / 自定义),每个配置仅需3~4个字段(name、baseURL、model、token),自动清理环境变量避免冲突,并以统一令牌管理启动Claude命令行。

● 🧰 内置预设

- Anthropic(官方)→ api.anthropic.com,模型:claude-sonnet-4-5-20250929

- Moonshot(智谱清言)→ api.moonshot.cn,模型:moonshot-v1-8k

- BigModel(智谱AI)→ open.bigmodel.cn,模型:glm-4-plus

- Custom → 自定义API或自建代理。

● 🔐 安全机制:Keytar系统密钥库存储

- macOS → Keychain

- Windows → Credential Vault

- Linux → Secret Service API

若缺失依赖则自动回退至本地文件(明文存储),并提示风险。

● 💡 交互式配置与切换

- ai-claude-start setup:交互式创建或修改配置

- ai-claude-start list:查看所有配置及凭证状态

- ai-claude-start default <name>:设为默认配置

- claude-start:自动弹出多配置选择菜单

- 还可通过alias自定义命令快速切换不同环境。

● 🧪 测试与开发支持

提供 --cmd 参数或 CLAUDE_CMD 环境变量模拟Claude执行,无需真实CLI即可测试环境变量注入,非常适合CI/CD或多环境调试。

● 🧩 环境变量注入机制

启动时自动注入以下变量:

- ANTHROPIC_AUTH_TOKEN:安全凭证

- ANTHROPIC_BASE_URL:API地址(若非官方)

并在启动前清理所有旧的ANTHROPIC_*变量,防止冲突。

● 🧠 适配场景

- 多地区部署:在中国大陆、海外或自建代理间快速切换

- 多供应商混合使用:如Claude、Moonshot、智谱混跑

- 安全团队或企业开发环境:集中配置、统一鉴权。

ai-claude-start:多配置Claude命令行启动器

GitHub - op7418/ai-claude-start: Multi-profile Claude Code launcher with secure credential management

🧐一句话总结:

该工具是一个可同时管理多个Claude API配置的安全命令行启动器,支持Anthropic、Moonshot、智谱(BigModel)等兼容API,通过系统密钥库安全存储凭证,实现多环境快速切换与一键启动Claude CLI。

➡️链接:github.com

✨重点

● ⚙️ 核心功能:多配置 + 安全凭证管理

支持多个Claude风格API配置(Anthropic / Moonshot / BigModel / 自定义),每个配置仅需3~4个字段(name、baseURL、model、token),自动清理环境变量避免冲突,并以统一令牌管理启动Claude命令行。

● 🧰 内置预设

- Anthropic(官方)→ api.anthropic.com,模型:claude-sonnet-4-5-20250929

- Moonshot(智谱清言)→ api.moonshot.cn,模型:moonshot-v1-8k

- BigModel(智谱AI)→ open.bigmodel.cn,模型:glm-4-plus

- Custom → 自定义API或自建代理。

● 🔐 安全机制:Keytar系统密钥库存储

- macOS → Keychain

- Windows → Credential Vault

- Linux → Secret Service API

若缺失依赖则自动回退至本地文件(明文存储),并提示风险。

● 💡 交互式配置与切换

- ai-claude-start setup:交互式创建或修改配置

- ai-claude-start list:查看所有配置及凭证状态

- ai-claude-start default <name>:设为默认配置

- claude-start:自动弹出多配置选择菜单

- 还可通过alias自定义命令快速切换不同环境。

● 🧪 测试与开发支持

提供 --cmd 参数或 CLAUDE_CMD 环境变量模拟Claude执行,无需真实CLI即可测试环境变量注入,非常适合CI/CD或多环境调试。

● 🧩 环境变量注入机制

启动时自动注入以下变量:

- ANTHROPIC_AUTH_TOKEN:安全凭证

- ANTHROPIC_BASE_URL:API地址(若非官方)

并在启动前清理所有旧的ANTHROPIC_*变量,防止冲突。

● 🧠 适配场景

- 多地区部署:在中国大陆、海外或自建代理间快速切换

- 多供应商混合使用:如Claude、Moonshot、智谱混跑

- 安全团队或企业开发环境:集中配置、统一鉴权。

0 02

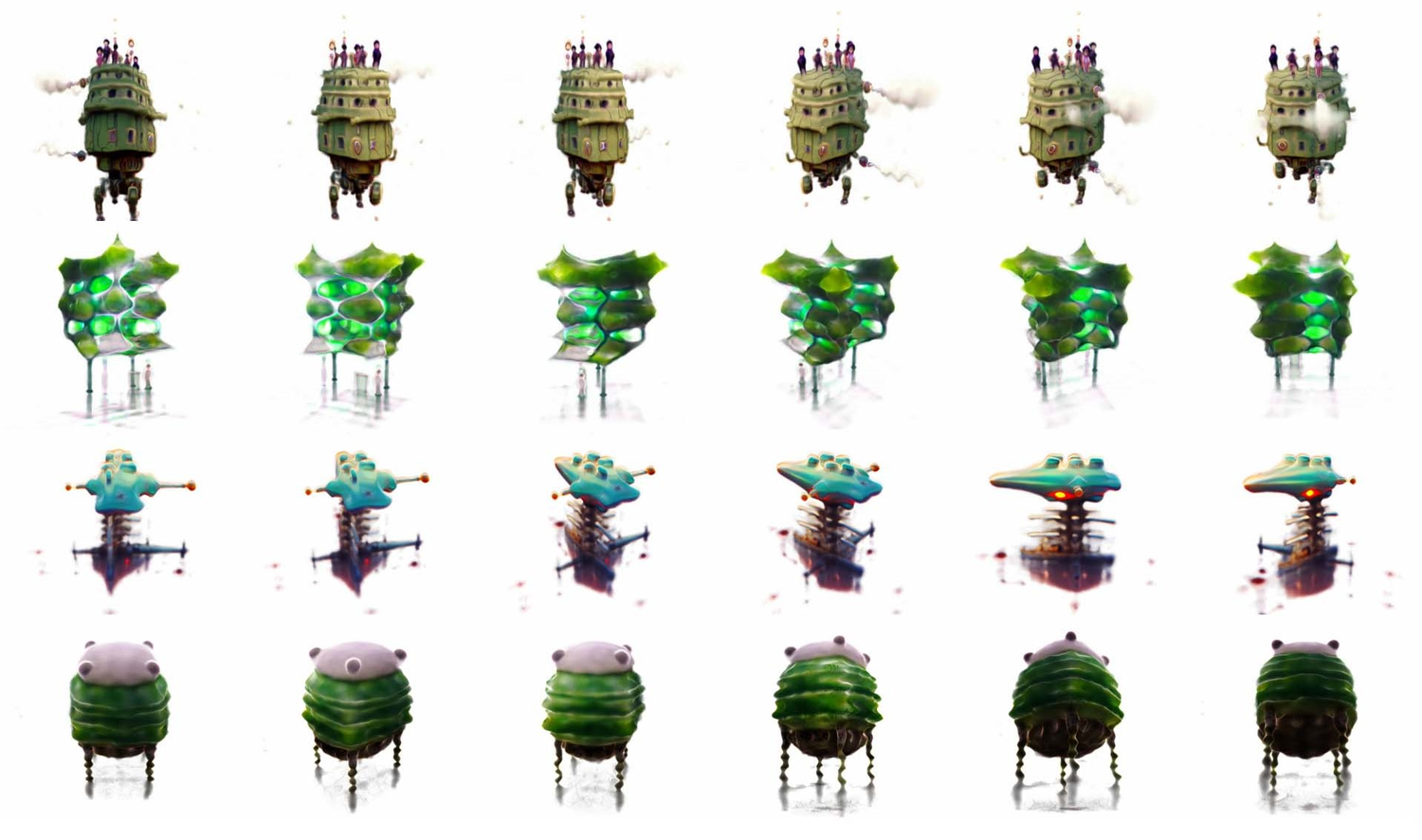

单图/文生成完成完整3D高斯空间的开源模型,而且又好又快~?!🫨

FlashWorld:7秒内生成高质量3D场景的世界生成模型

来自厦门大学 × 腾讯 × 复旦Yes Lab(arXiv:2510.13678)

🧐一句话总结:

FlashWorld 是首个能在单张GPU上7秒内生成高保真3D场景的生成模型,通过“双模训练+跨模蒸馏”,融合了多视图生成与3D一致性生成的优势,实现了速度、质量与空间一致性的三者平衡。

➡️链接:t.co

论文原文:arxiv.org

✨重点

● ⚙️ 技术突破:从多视图导向到3D导向的新范式

传统方法(MV-oriented)先生成多视图再重建3D,画面清晰但空间一致性差;

而FlashWorld转向“3D导向生成(3D-oriented generation)”,直接生成3D高斯表示(3D Gaussian Representation),在生成过程中保持几何一致性。

● 🧩 双模训练 + 跨模蒸馏(Cross-Mode Distillation)机制

模型先以“多视图模式 + 3D模式”联合预训练(dual-mode pre-training),

再进行“跨模蒸馏”:

- 教师模型(Teacher):高质量的多视图生成模型;

- 学生模型(Student):保持3D一致性的3D导向模型;

通过分布匹配学习,使学生模型兼具清晰度与一致性。

● 🚀 速度优势显著:单GPU七秒出世界

在一张GPU上即可在7秒内生成高保真3D场景,较现有NeRF、3D Diffusion、Gaussian Splatting类模型快一个数量级。

推理阶段还通过蒸馏减少去噪步数,大幅降低延迟。

● 🧠 引入视频扩散模型先验(Video Diffusion Prior)

FlashWorld以视频扩散模型为基础,使模型具备对时空一致性与光照变化的天然适应力,能从单张图像或文本Prompt生成动态一致的3D世界。

● 🧱 统一生成接口:图像 / 文本 → 3D场景

输入:一张图片或一句自然语言描述;

输出:可交互的3D高斯场景,可渲染多视角影像。

适合VR、数字孪生、AI世界生成等领域。

● 🔍 训练数据与泛化策略

通过大量**单视图图像与文本提示(text prompt)**的预训练增强模型的分布外泛化能力,解决真实场景中相机标注不准和数据稀疏问题。

● 🧪 实验结果

FlashWorld在渲染质量、一致性与推理速度三方面全面领先:

- 比领先模型快3-5倍;

- 画面更锐利、空间畸变更小;

- 可扩展到复杂城市级3D场景。

● 💡 研究意义

FlashWorld让“3D生成”从离线重建迈入**实时生成(Real-time World Generation)**阶段,

是通向“AI自生成世界(AI World Models)”的重要中间层。

💡一句话洞察:

FlashWorld 把 3D 世界生成的速度提升到“实时级”——让AI不再只是渲染静态画面,而是能“即时创造可探索的世界”。

FlashWorld:7秒内生成高质量3D场景的世界生成模型

来自厦门大学 × 腾讯 × 复旦Yes Lab(arXiv:2510.13678)

🧐一句话总结:

FlashWorld 是首个能在单张GPU上7秒内生成高保真3D场景的生成模型,通过“双模训练+跨模蒸馏”,融合了多视图生成与3D一致性生成的优势,实现了速度、质量与空间一致性的三者平衡。

➡️链接:t.co

论文原文:arxiv.org

✨重点

● ⚙️ 技术突破:从多视图导向到3D导向的新范式

传统方法(MV-oriented)先生成多视图再重建3D,画面清晰但空间一致性差;

而FlashWorld转向“3D导向生成(3D-oriented generation)”,直接生成3D高斯表示(3D Gaussian Representation),在生成过程中保持几何一致性。

● 🧩 双模训练 + 跨模蒸馏(Cross-Mode Distillation)机制

模型先以“多视图模式 + 3D模式”联合预训练(dual-mode pre-training),

再进行“跨模蒸馏”:

- 教师模型(Teacher):高质量的多视图生成模型;

- 学生模型(Student):保持3D一致性的3D导向模型;

通过分布匹配学习,使学生模型兼具清晰度与一致性。

● 🚀 速度优势显著:单GPU七秒出世界

在一张GPU上即可在7秒内生成高保真3D场景,较现有NeRF、3D Diffusion、Gaussian Splatting类模型快一个数量级。

推理阶段还通过蒸馏减少去噪步数,大幅降低延迟。

● 🧠 引入视频扩散模型先验(Video Diffusion Prior)

FlashWorld以视频扩散模型为基础,使模型具备对时空一致性与光照变化的天然适应力,能从单张图像或文本Prompt生成动态一致的3D世界。

● 🧱 统一生成接口:图像 / 文本 → 3D场景

输入:一张图片或一句自然语言描述;

输出:可交互的3D高斯场景,可渲染多视角影像。

适合VR、数字孪生、AI世界生成等领域。

● 🔍 训练数据与泛化策略

通过大量**单视图图像与文本提示(text prompt)**的预训练增强模型的分布外泛化能力,解决真实场景中相机标注不准和数据稀疏问题。

● 🧪 实验结果

FlashWorld在渲染质量、一致性与推理速度三方面全面领先:

- 比领先模型快3-5倍;

- 画面更锐利、空间畸变更小;

- 可扩展到复杂城市级3D场景。

● 💡 研究意义

FlashWorld让“3D生成”从离线重建迈入**实时生成(Real-time World Generation)**阶段,

是通向“AI自生成世界(AI World Models)”的重要中间层。

💡一句话洞察:

FlashWorld 把 3D 世界生成的速度提升到“实时级”——让AI不再只是渲染静态画面,而是能“即时创造可探索的世界”。

00:47

1 02

这个平台有意思——上传你的视频/图片,然后做成交互视频游戏~!

Justine Moore 在 X 上发文: “我们正经历视频模型的一个非凡时代。”

🧐通过单一文本提示生成的视频模型,未来将可能实现完全互动,实时控制场景演变。

➡️平台链接:rosebud.ai

➡️原文链接:t.co

✨重点

●🤯 当前视频模型技术允许从简单的提示生成复杂场景,标志着创意表达的新纪元。

●🎮 互动视频将重现 1990 年代的互动 CD 游戏体验,用户可以在场景中做出选择。

●📈 Moore 的 TikTok 视频获得了 27 万次观看,展示了如何将选择自己的故事与流行文化结合。

●👻 视频模型能够精准捕捉用户的动作和情感,提升了沉浸感和互动性。

●🛠️ 当前技术的限制在于每次生成只能基于一次提示,未来可希望实现对角度、光线和时机的调整。

●🔗 用户可以通过 Rosebud.ai 等平台实现视频的分支创建,降低了制作复杂互动视频的门槛。

●🎭 内容创作者在设计角色时需要注意用词,特定的描述可能会影响生成结果。

Justine Moore 在 X 上发文: “我们正经历视频模型的一个非凡时代。”

🧐通过单一文本提示生成的视频模型,未来将可能实现完全互动,实时控制场景演变。

➡️平台链接:rosebud.ai

➡️原文链接:t.co

✨重点

●🤯 当前视频模型技术允许从简单的提示生成复杂场景,标志着创意表达的新纪元。

●🎮 互动视频将重现 1990 年代的互动 CD 游戏体验,用户可以在场景中做出选择。

●📈 Moore 的 TikTok 视频获得了 27 万次观看,展示了如何将选择自己的故事与流行文化结合。

●👻 视频模型能够精准捕捉用户的动作和情感,提升了沉浸感和互动性。

●🛠️ 当前技术的限制在于每次生成只能基于一次提示,未来可希望实现对角度、光线和时机的调整。

●🔗 用户可以通过 Rosebud.ai 等平台实现视频的分支创建,降低了制作复杂互动视频的门槛。

●🎭 内容创作者在设计角色时需要注意用词,特定的描述可能会影响生成结果。

00:10

5 23

这个好酷~! 从单目视频快速重建人物动作姿态及3D场景~!

Human3R:Everyone Everywhere All at Once

(Human3R:人人、处处、同时重建)

🧐一句话总结:

Human3R 是首个能在单阶段、单GPU上一天训练完成的「统一4D人-场景实时重建模型」,实现了多人物体、相机与场景的“一次性端到端重建”,打破了以往3D/4D重建需多阶段依赖与高算力的技术壁垒。

➡️链接:fanegg.github.io

✨重点

●⚙️ 核心创新:All-in-One Reconstruction(一次成型重建)

Human3R 可从普通单目视频中实时(15FPS)直接重建多人姿态、相机轨迹与三维场景几何,无需检测、SLAM、深度估计或逐帧优化。

●🧠 技术路线:端到端视觉Prompt微调

在前作 CUT3R 模型基础上,Human3R 仅微调人类相关层,其余参数冻结,借助视觉Prompt调优保留时空先验,实现极高参数效率。

●👥 “Everyone Everywhere All at Once”含义

“Everyone”指同时支持多人物体重建;“Everywhere”指全局三维场景重建;“All at once”意味着单次前向推理完成所有任务——统一而非多阶段流水线。

●💻 训练成本极低

模型仅需在 BEDLAM 合成数据集上用一块GPU训练一天,即可达到SOTA或可竞争性能,这在4D reconstruction领域极具颠覆性。

●🌍 输出内容包括:

1️⃣ 多人SMPL-X网格体姿态

2️⃣ 稠密3D场景几何

3️⃣ 实时相机轨迹估计

全部在世界坐标系下联合推理完成。

●📉 失败与挑战

目前仍可能出现人-场景穿透、物体交互不自然等问题,未来可通过接触感知优化(contact-aware refinement)进一步改进。

●🧩 对比传统方法的优势

相比需要多阶段拟合与测试时训练(如 TTT3R、TRAM),Human3R 将人、相机、场景全部纳入统一Transformer架构中,显著简化流程与计算。

●🚀 科学与工程意义

Human3R 为“在线4D重建”提供了强基线,证明单模型即可实现多任务并行推理,为未来虚拟人、AR/VR、机器人视觉奠定高效基础。

Human3R:Everyone Everywhere All at Once

(Human3R:人人、处处、同时重建)

🧐一句话总结:

Human3R 是首个能在单阶段、单GPU上一天训练完成的「统一4D人-场景实时重建模型」,实现了多人物体、相机与场景的“一次性端到端重建”,打破了以往3D/4D重建需多阶段依赖与高算力的技术壁垒。

➡️链接:fanegg.github.io

✨重点

●⚙️ 核心创新:All-in-One Reconstruction(一次成型重建)

Human3R 可从普通单目视频中实时(15FPS)直接重建多人姿态、相机轨迹与三维场景几何,无需检测、SLAM、深度估计或逐帧优化。

●🧠 技术路线:端到端视觉Prompt微调

在前作 CUT3R 模型基础上,Human3R 仅微调人类相关层,其余参数冻结,借助视觉Prompt调优保留时空先验,实现极高参数效率。

●👥 “Everyone Everywhere All at Once”含义

“Everyone”指同时支持多人物体重建;“Everywhere”指全局三维场景重建;“All at once”意味着单次前向推理完成所有任务——统一而非多阶段流水线。

●💻 训练成本极低

模型仅需在 BEDLAM 合成数据集上用一块GPU训练一天,即可达到SOTA或可竞争性能,这在4D reconstruction领域极具颠覆性。

●🌍 输出内容包括:

1️⃣ 多人SMPL-X网格体姿态

2️⃣ 稠密3D场景几何

3️⃣ 实时相机轨迹估计

全部在世界坐标系下联合推理完成。

●📉 失败与挑战

目前仍可能出现人-场景穿透、物体交互不自然等问题,未来可通过接触感知优化(contact-aware refinement)进一步改进。

●🧩 对比传统方法的优势

相比需要多阶段拟合与测试时训练(如 TTT3R、TRAM),Human3R 将人、相机、场景全部纳入统一Transformer架构中,显著简化流程与计算。

●🚀 科学与工程意义

Human3R 为“在线4D重建”提供了强基线,证明单模型即可实现多任务并行推理,为未来虚拟人、AR/VR、机器人视觉奠定高效基础。

00:38

6 03

感觉是李飞飞那个图转世界的开源青春版🥹

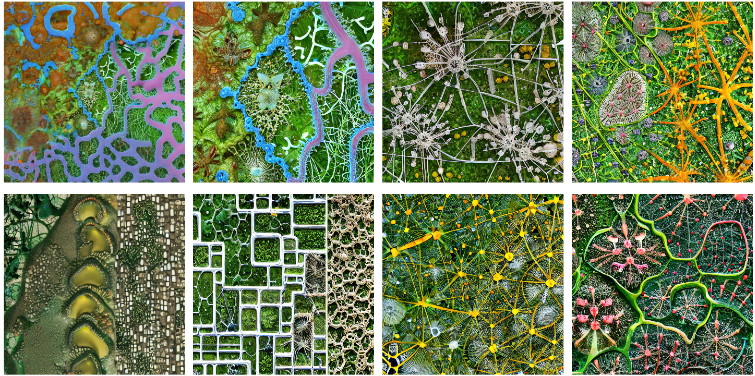

WorldExplorer: Towards Generating Fully Navigable 3D Scenes

🧐 这是慕尼黑工业大学团队在 SIGGRAPH Asia 2025 提出的 WorldExplorer,一种通过 相机引导的视频扩散模型 + 3D 高斯点渲染,实现从文本生成可完全自由探索的 3D 场景的方法,首次突破了现有方法中“只能在中心或全景视角下保持质量”的限制。

➡️链接:mschneider456.github.io

✨重点

● 🏗️ 核心目标:从自然语言 Prompt 自动生成高质量、可自由导航的 3D 场景,支持真实感视角移动。

● 🎥 三阶段生成流程:

初始 Scaffold:用 T2I 模型生成 4 张环绕中心的全景图,再补齐深度与修复生成 8 张初始图像;

视频轨迹扩展:基于相机引导的视频扩散模型,迭代生成多段短视频帧,模拟相机围绕物体移动;

3D 优化重建:将所有图像融合,利用 3D Gaussian Splatting (3DGS) 优化为可实时渲染的完整场景。

● 🧠 关键技术:

场景记忆 (Scene Memory):每次视频生成时选择最相关的先前帧作为条件,确保多视角一致性;

碰撞检测:避免相机“撞到物体”,减少失真与伪影;

VGGT + 刚体配准:点云初始化与相机位姿全局对齐。

● 🌍 可交互体验:提供在线 3DGS Viewer,可以实时加载 Jellyfish、Liquid Metal Monastery、Hamptons Beach House 等生成场景,支持鼠标/键盘/触摸自由漫游。

● 📊 突破点:相比现有方法,生成的 3D 世界在大范围相机运动下依然稳定、无拉伸和噪点伪影,真正接近沉浸式虚拟环境。

● 📖 学术成果:对应论文已上传 arXiv(arXiv:2506.01799),将在 SIGGRAPH Asia 2025 发表。

WorldExplorer: Towards Generating Fully Navigable 3D Scenes

🧐 这是慕尼黑工业大学团队在 SIGGRAPH Asia 2025 提出的 WorldExplorer,一种通过 相机引导的视频扩散模型 + 3D 高斯点渲染,实现从文本生成可完全自由探索的 3D 场景的方法,首次突破了现有方法中“只能在中心或全景视角下保持质量”的限制。

➡️链接:mschneider456.github.io

✨重点

● 🏗️ 核心目标:从自然语言 Prompt 自动生成高质量、可自由导航的 3D 场景,支持真实感视角移动。

● 🎥 三阶段生成流程:

初始 Scaffold:用 T2I 模型生成 4 张环绕中心的全景图,再补齐深度与修复生成 8 张初始图像;

视频轨迹扩展:基于相机引导的视频扩散模型,迭代生成多段短视频帧,模拟相机围绕物体移动;

3D 优化重建:将所有图像融合,利用 3D Gaussian Splatting (3DGS) 优化为可实时渲染的完整场景。

● 🧠 关键技术:

场景记忆 (Scene Memory):每次视频生成时选择最相关的先前帧作为条件,确保多视角一致性;

碰撞检测:避免相机“撞到物体”,减少失真与伪影;

VGGT + 刚体配准:点云初始化与相机位姿全局对齐。

● 🌍 可交互体验:提供在线 3DGS Viewer,可以实时加载 Jellyfish、Liquid Metal Monastery、Hamptons Beach House 等生成场景,支持鼠标/键盘/触摸自由漫游。

● 📊 突破点:相比现有方法,生成的 3D 世界在大范围相机运动下依然稳定、无拉伸和噪点伪影,真正接近沉浸式虚拟环境。

● 📖 学术成果:对应论文已上传 arXiv(arXiv:2506.01799),将在 SIGGRAPH Asia 2025 发表。

00:58

3 01

关于AI是否会抢人类工作,这篇论文给出了答案:不是可能,不是未来,AI已经在抢人类的饭碗了(目前还是初级工种,未来尚未可知)。

真实、残酷的 AI 就业冲击,从一篇极其精彩的哈佛论文聊起

🧐 本文基于哈佛最新研究揭示,AI并非通过大规模裁员,而是通过“不再招聘初级岗位”隐蔽地抽掉年轻人职业起点,中上等大学毕业生反而成了最危险的群体。

➡️链接:mp.weixin.qq.com

✨重点

● 📉 初级岗位断崖式下跌:2022年底ChatGPT发布后,美国初级岗位招聘首次出现负增长,2023年明显分化,高级岗位继续增长。

● 🧪 研究方法:利用LinkedIn招聘大数据+“双重差分”方法,将10.6万家AI采纳公司作为实验组,精准锁定AI影响。

● 🚪 AI冲击方式:公司并没有大规模裁掉初级员工,而是停止招聘新人,导致年轻人职业“第一阶梯”被抽掉。

● 🛍️ 行业差异:批发和零售业受冲击最大,AI显著替代客服、文员、导购等岗位,每季度初级招聘骤减40%。

● 🎓 学历悖论:顶尖名校毕业生因能力稀缺,普通学校毕业生因性价比高都相对安全;最危险的是中上等大学毕业生,高不成低不就,最易被AI取代。

● ⏰ 职业启示:必须加速从初级向独立承担复杂任务跃迁,工作内容中AI难以替代的部分要尽快超过50%。

● 🕵️ 暗知识与元技能:AI已经“满级”掌握公共知识,竞争力在于能提供独特上下文的暗知识和能解释“为什么”的元技能。

● 💡 兴趣的ROI:审美、幽默、同理心等过去的“软优势”,正在成为AI时代不可替代的核心竞争力,应主动将兴趣与AI结合。

真实、残酷的 AI 就业冲击,从一篇极其精彩的哈佛论文聊起

🧐 本文基于哈佛最新研究揭示,AI并非通过大规模裁员,而是通过“不再招聘初级岗位”隐蔽地抽掉年轻人职业起点,中上等大学毕业生反而成了最危险的群体。

➡️链接:mp.weixin.qq.com

✨重点

● 📉 初级岗位断崖式下跌:2022年底ChatGPT发布后,美国初级岗位招聘首次出现负增长,2023年明显分化,高级岗位继续增长。

● 🧪 研究方法:利用LinkedIn招聘大数据+“双重差分”方法,将10.6万家AI采纳公司作为实验组,精准锁定AI影响。

● 🚪 AI冲击方式:公司并没有大规模裁掉初级员工,而是停止招聘新人,导致年轻人职业“第一阶梯”被抽掉。

● 🛍️ 行业差异:批发和零售业受冲击最大,AI显著替代客服、文员、导购等岗位,每季度初级招聘骤减40%。

● 🎓 学历悖论:顶尖名校毕业生因能力稀缺,普通学校毕业生因性价比高都相对安全;最危险的是中上等大学毕业生,高不成低不就,最易被AI取代。

● ⏰ 职业启示:必须加速从初级向独立承担复杂任务跃迁,工作内容中AI难以替代的部分要尽快超过50%。

● 🕵️ 暗知识与元技能:AI已经“满级”掌握公共知识,竞争力在于能提供独特上下文的暗知识和能解释“为什么”的元技能。

● 💡 兴趣的ROI:审美、幽默、同理心等过去的“软优势”,正在成为AI时代不可替代的核心竞争力,应主动将兴趣与AI结合。

1 00

GitHub - QwenLM/Qwen3-Omni,省流:原生多模态模型,支持文本/图像/语音/视频输入,支持实时流式文字/语音输出,30B规模。

🧐 这是阿里云通义千问团队发布的 端到端原生多模态大模型 Qwen3-Omni,可处理文本、图像、音频、视频,并支持实时语音生成,开源提供使用指南、Cookbooks、评测与多种部署方式。

➡️链接:github.com

✨重点

●🎤 多模态能力:支持文本、图像、音频、视频输入,并能实时生成文本和语音输出,覆盖语音识别、翻译、音乐分析、视频描述、音视频交互等任务。

●🌍 多语言支持:文本覆盖 119 种语言,语音输入支持 19 种语言,语音输出支持 10 种语言,媲美 Gemini 2.5 Pro。

●🧠 架构创新:采用 MoE(专家混合)Thinker–Talker 架构和 AuT 预训练,结合多码本设计显著降低推理延迟。

●📊 性能领先:在 36 个音频/视听基准测试中,32 项取得开源 SOTA,22 项刷新整体 SOTA。

●🛠️ 使用指南:提供 Hugging Face Transformers、vLLM、DashScope API、Docker 镜像及本地 Web UI demo,适配多种开发和部署环境。

●📚 Cookbooks 应用示例:涵盖语音识别、音乐分析、OCR、图像问答、视频导航、音视频对话等详细用例,附带执行日志。

●🎛️ 灵活交互:支持实时流式交互、低延迟自然对话,可通过系统提示词自定义角色和输出风格。

●📥 模型版本:已开放 Qwen3-Omni-30B-A3B-Instruct(推理+对话)、Thinking(推理为主)、Captioner(音频精细描述)三类模型下载与调用。

●🚀 部署优化:推荐使用 vLLM 获取高并发与低延迟,Transformers 版本可启用 FlashAttention 2,Docker 镜像则简化 GPU 环境部署。

●🔬 评测细节:提供不同任务的 prompt 规范和 GPU 显存需求表格,明确优化方向与硬件要求。

🧐 这是阿里云通义千问团队发布的 端到端原生多模态大模型 Qwen3-Omni,可处理文本、图像、音频、视频,并支持实时语音生成,开源提供使用指南、Cookbooks、评测与多种部署方式。

➡️链接:github.com

✨重点

●🎤 多模态能力:支持文本、图像、音频、视频输入,并能实时生成文本和语音输出,覆盖语音识别、翻译、音乐分析、视频描述、音视频交互等任务。

●🌍 多语言支持:文本覆盖 119 种语言,语音输入支持 19 种语言,语音输出支持 10 种语言,媲美 Gemini 2.5 Pro。

●🧠 架构创新:采用 MoE(专家混合)Thinker–Talker 架构和 AuT 预训练,结合多码本设计显著降低推理延迟。

●📊 性能领先:在 36 个音频/视听基准测试中,32 项取得开源 SOTA,22 项刷新整体 SOTA。

●🛠️ 使用指南:提供 Hugging Face Transformers、vLLM、DashScope API、Docker 镜像及本地 Web UI demo,适配多种开发和部署环境。

●📚 Cookbooks 应用示例:涵盖语音识别、音乐分析、OCR、图像问答、视频导航、音视频对话等详细用例,附带执行日志。

●🎛️ 灵活交互:支持实时流式交互、低延迟自然对话,可通过系统提示词自定义角色和输出风格。

●📥 模型版本:已开放 Qwen3-Omni-30B-A3B-Instruct(推理+对话)、Thinking(推理为主)、Captioner(音频精细描述)三类模型下载与调用。

●🚀 部署优化:推荐使用 vLLM 获取高并发与低延迟,Transformers 版本可启用 FlashAttention 2,Docker 镜像则简化 GPU 环境部署。

●🔬 评测细节:提供不同任务的 prompt 规范和 GPU 显存需求表格,明确优化方向与硬件要求。

2 01

好家伙,带3D controlnet的3D生成模型🥹:通过点云、体素、骨骼、包围盒等多模态条件实现更精细的 3D 建模控制。话说国内几个大厂感觉都进化成源神了😂

GitHub - Tencent-Hunyuan/Hunyuan3D-Omni

🧐 腾讯混元团队推出的 Hunyuan3D-Omni 是一个统一的 可控 3D 资产生成框架,在继承 Hunyuan3D 2.1 的基础上,新增统一控制编码器,可通过点云、体素、骨骼、包围盒等多模态条件实现更精细的 3D 建模控制。

➡️链接:github.com

✨重点

● 🏗️ 统一框架:在 Hunyuan3D 2.1 的基础上升级,核心亮点是引入统一控制编码器,支持多模态约束生成。

● 📦 多模态控制:

Bounding Box Control:生成符合三维包围盒约束的 3D 模型;

Pose Control:根据骨骼姿态生成 3D 人体模型;

Point Cloud Control:用点云数据引导模型生成;

Voxel Control:通过体素输入生成 3D 形体。

● 🚀 推理与优化:提供 inference.py,支持 --control_type 指定控制方式,并可加 --use_ema 提升稳定性,--flashvdm 加速推理。

● 💻 硬件需求:生成一次需要约 10GB 显存,较为轻量。

● 🎁 模型 Zoo:已在 Hugging Face 提供 33 亿参数的 Image-to-Shape 多模态控制模型(2025-09-25 发布)。

● 🔗 技术依赖:参考了 TripoSG、Stable Diffusion、DINOv2、diffusers、CraftsMan3D 等开源项目。

● 📖 学术成果:对应论文已上传 arXiv(2509.21245),并在系列论文中延续 Hunyuan3D 1.0 → 2.0 → 2.1 → Omni 的发展脉络。

● 🛠️ 使用门槛低:基于 Python 3.10 和 PyTorch 2.5.1,安装简单。

GitHub - Tencent-Hunyuan/Hunyuan3D-Omni

🧐 腾讯混元团队推出的 Hunyuan3D-Omni 是一个统一的 可控 3D 资产生成框架,在继承 Hunyuan3D 2.1 的基础上,新增统一控制编码器,可通过点云、体素、骨骼、包围盒等多模态条件实现更精细的 3D 建模控制。

➡️链接:github.com

✨重点

● 🏗️ 统一框架:在 Hunyuan3D 2.1 的基础上升级,核心亮点是引入统一控制编码器,支持多模态约束生成。

● 📦 多模态控制:

Bounding Box Control:生成符合三维包围盒约束的 3D 模型;

Pose Control:根据骨骼姿态生成 3D 人体模型;

Point Cloud Control:用点云数据引导模型生成;

Voxel Control:通过体素输入生成 3D 形体。

● 🚀 推理与优化:提供 inference.py,支持 --control_type 指定控制方式,并可加 --use_ema 提升稳定性,--flashvdm 加速推理。

● 💻 硬件需求:生成一次需要约 10GB 显存,较为轻量。

● 🎁 模型 Zoo:已在 Hugging Face 提供 33 亿参数的 Image-to-Shape 多模态控制模型(2025-09-25 发布)。

● 🔗 技术依赖:参考了 TripoSG、Stable Diffusion、DINOv2、diffusers、CraftsMan3D 等开源项目。

● 📖 学术成果:对应论文已上传 arXiv(2509.21245),并在系列论文中延续 Hunyuan3D 1.0 → 2.0 → 2.1 → Omni 的发展脉络。

● 🛠️ 使用门槛低:基于 Python 3.10 和 PyTorch 2.5.1,安装简单。

2 01

comyUI新支持的这个声音驱动人像视频和图像开源生成模型的质量好棒!

HuMo & Chroma1-Radiance ComfyUI原生支持现已发布!

🧐 ComfyUI 在 0.3.60 版本中正式原生支持 HuMo(多模态人类视频生成框架)和 Chroma1-Radiance(像素空间图像生成模型),大幅提升视频生成和图像生成的可控性与质量。

➡️链接:mp.weixin.qq.com

✨重点

● 🎥 HuMo 模型:

以人为中心的视频生成框架;

支持文本-图像、文本-音频、文本-图像-音频三种模式;

最高可生成 720P 视频,保持人物一致性;

音频驱动 → 动作与语音完美同步。

下载工作流模板:video_humo.json。

● 🖼️ Chroma1-Radiance 模型:

由 @LodestoneRock 团队开发,Apache-2.0 协议(可商用);

与普通模型依赖 VAE 不同,直接在像素空间生成图像;

无需 VAE 解码 → 减少信息损失,预览更精准;

擅长超写实、高分辨率、细节丰富的图像生成。

下载工作流模板:image_chroma1_radiance_text_to_image.json。

HuMo & Chroma1-Radiance ComfyUI原生支持现已发布!

🧐 ComfyUI 在 0.3.60 版本中正式原生支持 HuMo(多模态人类视频生成框架)和 Chroma1-Radiance(像素空间图像生成模型),大幅提升视频生成和图像生成的可控性与质量。

➡️链接:mp.weixin.qq.com

✨重点

● 🎥 HuMo 模型:

以人为中心的视频生成框架;

支持文本-图像、文本-音频、文本-图像-音频三种模式;

最高可生成 720P 视频,保持人物一致性;

音频驱动 → 动作与语音完美同步。

下载工作流模板:video_humo.json。

● 🖼️ Chroma1-Radiance 模型:

由 @LodestoneRock 团队开发,Apache-2.0 协议(可商用);

与普通模型依赖 VAE 不同,直接在像素空间生成图像;

无需 VAE 解码 → 减少信息损失,预览更精准;

擅长超写实、高分辨率、细节丰富的图像生成。

下载工作流模板:image_chroma1_radiance_text_to_image.json。

00:03

0 00

腾讯推出了迄今为止最强的开源多模态图像推理生成模型,感觉一个模型就可以把之前图像Agent的事情干了:生成带文字的多步骤示意图、生成带艺术字的海报、生成AI味很淡的高清图像🥹 虽然但是,这个模型居然有80B!!😂 不过还好现在可以在官网试玩。

tencent/HunyuanImage-3.0 · Hugging Face

🧐 腾讯推出的 HunyuanImage-3.0 是目前最大开源 MoE 图像生成模型(总参数 800 亿,激活 130 亿/Token),采用统一自回归多模态架构,支持推理增强、自动 Prompt 重写,在语义准确性与视觉效果上可媲美甚至超越闭源模型。

➡️链接:huggingface.co

➡️试玩:hunyuan.tencent.com

✨重点

● 🧠 架构创新:突破常见的 DiT 架构,采用统一自回归多模态框架,直接融合文本与图像建模,提升上下文理解与生成一致性。

● 🏆 规模领先:是目前最大的开源图像生成 MoE 模型,共 64 个专家,800 亿参数,激活参数量 130 亿/Token。

● 🎨 生成质量:通过精细数据集与 RL 后训练,兼顾语义精准与美学效果,支持高保真、细节丰富的写实图像。

● 💭 推理增强:能结合世界知识智能扩写稀疏 Prompt,生成更完整、细腻的画面。

● ⚙️ 运行要求:推荐 Linux + Python 3.12 + PyTorch 2.7.1 + CUDA 12.8;需要 ≥3×80GB 显存,权重文件约 170GB。

● ⚡ 性能优化:支持 FlashAttention 2 与 FlashInfer 加速,推理速度最高可提升 3 倍。

● 🚀 使用方式:

Hugging Face Transformers 直接调用;

本地运行(支持 DeepSeek 系统提示词自动优化 Prompt);

提供 Gradio Web 界面 Demo。

● 🧱 模型版本:

HunyuanImage-3.0 Base:标准 Text-to-Image;

HunyuanImage-3.0 Instruct:带推理能力,支持 Prompt 自动重写与 Chain-of-Thought。

● 📊 评测方法:采用 SSAE(自动语义-图像对齐评估)与 GSB(人工优劣对比)双轨评价,涵盖 3500 个关键点与 1000 Prompt 的多维度测试。

● 📖 文档支持:已发布技术报告,提供 Prompt Handbook 与系统提示词(Universal / Text Rendering)。

tencent/HunyuanImage-3.0 · Hugging Face

🧐 腾讯推出的 HunyuanImage-3.0 是目前最大开源 MoE 图像生成模型(总参数 800 亿,激活 130 亿/Token),采用统一自回归多模态架构,支持推理增强、自动 Prompt 重写,在语义准确性与视觉效果上可媲美甚至超越闭源模型。

➡️链接:huggingface.co

➡️试玩:hunyuan.tencent.com

✨重点

● 🧠 架构创新:突破常见的 DiT 架构,采用统一自回归多模态框架,直接融合文本与图像建模,提升上下文理解与生成一致性。

● 🏆 规模领先:是目前最大的开源图像生成 MoE 模型,共 64 个专家,800 亿参数,激活参数量 130 亿/Token。

● 🎨 生成质量:通过精细数据集与 RL 后训练,兼顾语义精准与美学效果,支持高保真、细节丰富的写实图像。

● 💭 推理增强:能结合世界知识智能扩写稀疏 Prompt,生成更完整、细腻的画面。

● ⚙️ 运行要求:推荐 Linux + Python 3.12 + PyTorch 2.7.1 + CUDA 12.8;需要 ≥3×80GB 显存,权重文件约 170GB。

● ⚡ 性能优化:支持 FlashAttention 2 与 FlashInfer 加速,推理速度最高可提升 3 倍。

● 🚀 使用方式:

Hugging Face Transformers 直接调用;

本地运行(支持 DeepSeek 系统提示词自动优化 Prompt);

提供 Gradio Web 界面 Demo。

● 🧱 模型版本:

HunyuanImage-3.0 Base:标准 Text-to-Image;

HunyuanImage-3.0 Instruct:带推理能力,支持 Prompt 自动重写与 Chain-of-Thought。

● 📊 评测方法:采用 SSAE(自动语义-图像对齐评估)与 GSB(人工优劣对比)双轨评价,涵盖 3500 个关键点与 1000 Prompt 的多维度测试。

● 📖 文档支持:已发布技术报告,提供 Prompt Handbook 与系统提示词(Universal / Text Rendering)。

2 02